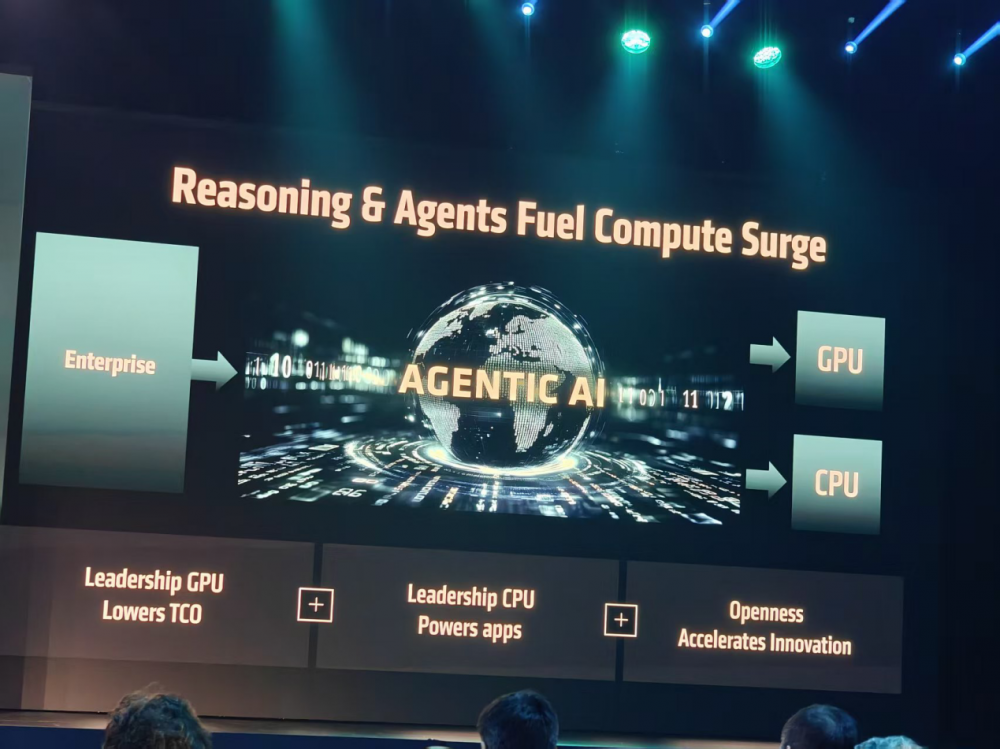

C114訊 6月13日消息(岳明)在Generative AI向Agentic AI的演進(jìn)浪潮中,要想繼續(xù)留在“牌桌”上,產(chǎn)品技術(shù)創(chuàng)新和產(chǎn)業(yè)生態(tài)合作同樣重要。

作為在Generative AI時(shí)代的贏家之一,AMD顯然想贏得更大的牌局,但這并非易事,AMD該如何破局?太平洋時(shí)間2025年6月12日上午9:30,AMD董事會(huì)主席及首席執(zhí)行官蘇姿豐(Lisa Su)博士在Advancing AI大會(huì)上給出了自己的答案:領(lǐng)先技術(shù)+開(kāi)放生態(tài)+全棧方案!

在領(lǐng)先技術(shù)層面,AMD瞄準(zhǔn)4000億美元的AI硬件市場(chǎng),已經(jīng)構(gòu)建起了包括CPU、GPU、DPU、FPGA等在內(nèi)的完整技術(shù)堆棧,而且在快速價(jià)值迭代;在開(kāi)放生態(tài)層面,AMD正在加大對(duì)ROCm軟件生態(tài)系統(tǒng)的建設(shè)投入,最新版本ROCm 7已經(jīng)面向生成式AI和高性能計(jì)算工作負(fù)載日益增長(zhǎng)的需求做足準(zhǔn)備;在全棧方案層面,AMD正在強(qiáng)化云邊端協(xié)同的集成 AI 平臺(tái)愿景,將推出基于行業(yè)標(biāo)準(zhǔn)構(gòu)建的、開(kāi)放且可擴(kuò)展的機(jī)架級(jí)AI基礎(chǔ)設(shè)施—“Helios”AI機(jī)柜。

技術(shù)領(lǐng)先:Instinct MI350系列GPU實(shí)現(xiàn)35倍推理性能提升

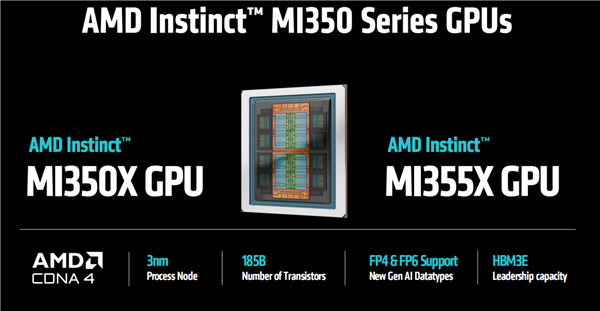

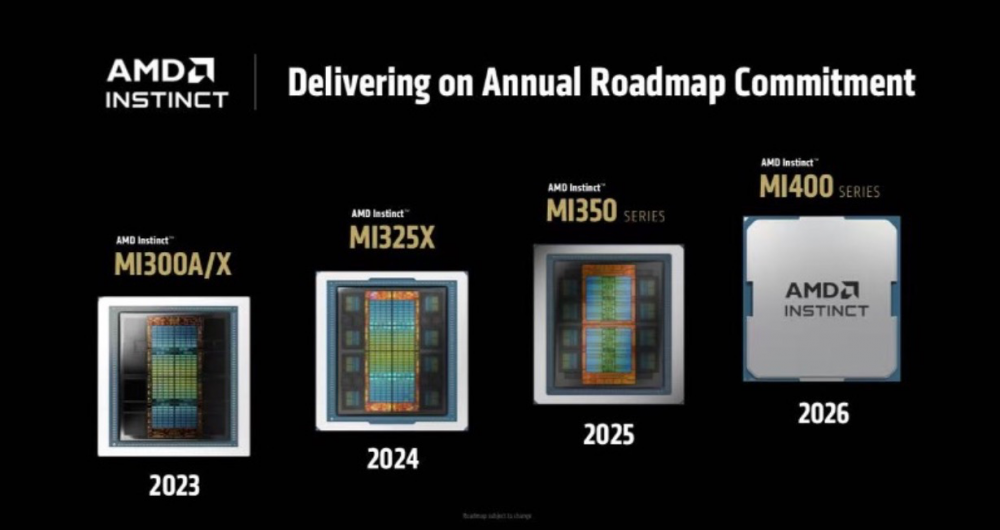

在上午的發(fā)布環(huán)節(jié),采用臺(tái)積電的3nm工藝,集成1850億晶體管的Instinct MI350系列GPU無(wú)疑是最大亮點(diǎn)。

作為AMD歷史上最為成功的產(chǎn)品之一,Instinct MI350系列GPU采用了CDNA 4架構(gòu),在性能、內(nèi)存容量、帶寬,GPU執(zhí)行單元數(shù)量、吞吐性能等方面實(shí)現(xiàn)了全面進(jìn)化,并且通過(guò)2.5D和3D先進(jìn)封裝技術(shù)實(shí)現(xiàn)了晶體管的更高密度集成以及更好的能效表現(xiàn)。

性能方能,Instinct MI350系列GPU支持多種浮點(diǎn)精度數(shù)據(jù)格式,包括FP8、FP6、FP4、FP16、BF16以及FP64等。相比前代產(chǎn)品,其AI算力得到顯著增強(qiáng),F(xiàn)P16性能達(dá)到18.5 PFlops,F(xiàn)P8為37 PFlops,F(xiàn)P6/FP4高達(dá)74 PFlops。MI350系列GPU的模型參數(shù)處理能力從7140億激增至4.2萬(wàn)億,提升近6倍,能夠有效滿足大語(yǔ)言模型和混合專家模型的訓(xùn)練與推理需求。

內(nèi)存和帶寬容量方面,這是AMD GPU產(chǎn)品區(qū)別于友商的強(qiáng)項(xiàng)。在Instinct MI350產(chǎn)品上,這種優(yōu)勢(shì)得到了進(jìn)一步加強(qiáng),其內(nèi)存容量達(dá)到了288GB HBM3E,最大帶寬能力為 8TB/s,無(wú)論是訓(xùn)練還是推理,都能獲得更好的吞吐量。

對(duì)于如此高算力、高密度的AI硬件產(chǎn)品而言,散熱和功耗是必須要面對(duì)的。Instinct MI350系列GPU可以支持風(fēng)冷和直接液冷靈活配置,風(fēng)冷機(jī)架中最多可部署64個(gè)GPU,液冷機(jī)架中最多可部署128個(gè)GPU,提供高達(dá)2.6 exaFLOPS 的 FP4/FP6 性能。

當(dāng)然,對(duì)于最終用戶而言,TCO是個(gè)更核心的話題。蘇姿豐博士介紹,相比英偉達(dá)B200,AMD Instinct MI300X系列GPU每美元可處理的Token數(shù)量提升高達(dá)40%,相當(dāng)于在運(yùn)行大語(yǔ)言模型(LLM)時(shí),單位成本下的計(jì)算效率提升40%。

而且在本次峰會(huì)上,AMD還劇透了下一代Instinct MI400系列GPU的特性,它將擁有高達(dá)40PF和20PF的FP4/FP8算力,并打在432GB HBM4內(nèi)存,帶寬將提升至19.6 TB/s,每個(gè)GPU的橫向擴(kuò)展帶寬將達(dá)到300 GB/s,進(jìn)一步為AI計(jì)算提速。

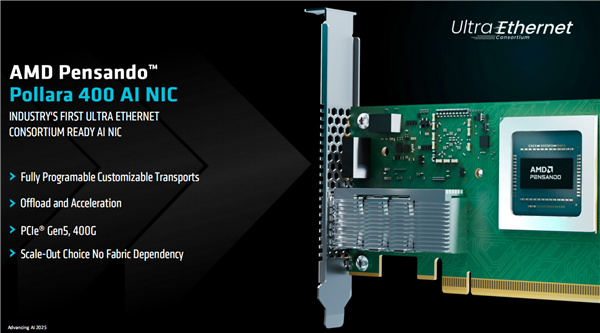

不僅在算力層面,在網(wǎng)絡(luò)連接層面,AMD推出了業(yè)界首款支持超以太網(wǎng)聯(lián)盟(UEC)特性的AI智能網(wǎng)卡——AMD Pensando Pollara 400,該AI智能網(wǎng)卡專為加速后端網(wǎng)絡(luò)應(yīng)用而設(shè)計(jì),實(shí)現(xiàn)了400千兆比特每秒(Gbps)的以太網(wǎng)傳輸速率。

開(kāi)放生態(tài):開(kāi)發(fā)者至上,全新ROCm 7+開(kāi)發(fā)者云

開(kāi)發(fā)者,開(kāi)發(fā)者,開(kāi)發(fā)者。

從會(huì)議現(xiàn)場(chǎng)某位演講嘉賓的開(kāi)場(chǎng)白中,我們就能深刻體會(huì)到軟件和生態(tài)的重要性,而這也是AMD最大競(jìng)爭(zhēng)對(duì)手英偉達(dá)的護(hù)城河。

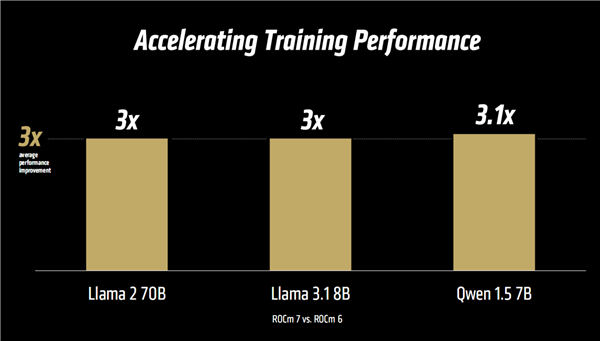

對(duì)此,蘇姿豐博士給出的答案是ROCm 7和開(kāi)發(fā)者云。AMD對(duì)ROCm的愿景是通過(guò)一個(gè)開(kāi)放、可擴(kuò)展且專注于開(kāi)發(fā)者的平臺(tái),為所有人解鎖創(chuàng)新潛能。據(jù)蘇姿豐博士介紹,過(guò)去一年中,ROCm迅速成熟,并深化了與主流開(kāi)源社區(qū)的集成。如今,ROCm驅(qū)動(dòng)著全球最大型的一些AI平臺(tái),支持Llama、DeepSeek等主流模型,特別是在最新的ROCm 7版本中實(shí)現(xiàn)了超過(guò) 3.5 倍的推理性能提升。

隨著AI應(yīng)用從研究轉(zhuǎn)向企業(yè)世紀(jì)部署,ROCm也在同步演進(jìn)。ROCm企業(yè)級(jí)AI將一套全棧式MLOps 平臺(tái)推向臺(tái)前,憑借支持超過(guò) 180萬(wàn)個(gè)Hugging Face模型的開(kāi)箱即用體驗(yàn),以及行業(yè)基準(zhǔn)測(cè)試的引入,ROCm提供用于微調(diào)、合規(guī)、部署和集成的開(kāi)箱即用工具,以實(shí)現(xiàn)安全、可擴(kuò)展的AI。“ROCm 不僅是在追趕——它正在引領(lǐng)開(kāi)放的AI革命”,蘇姿豐博士在演講中強(qiáng)調(diào)。

與ROCm 7相伴而來(lái)的,還有極具靈活性和可擴(kuò)展性的AMD開(kāi)發(fā)者云服務(wù)。AMD開(kāi)發(fā)者云服務(wù)具備零設(shè)置環(huán)境、支持預(yù)安裝的Docker容器和出色的靈活性、在Day-0生態(tài)的Instinct MI350系列GPU系統(tǒng)支持能力、擁有多元化的可擴(kuò)展計(jì)算選項(xiàng)、為開(kāi)發(fā)者提供免費(fèi)額度等多重亮點(diǎn)。也就是說(shuō),無(wú)論是何種應(yīng)用場(chǎng)景,AMD開(kāi)發(fā)者云都提供了即時(shí)開(kāi)始的工具和靈活性,讓開(kāi)發(fā)者在不受限制的環(huán)境中釋放生產(chǎn)力。

全棧方案:“Helios”AI機(jī)架實(shí)現(xiàn)“集大成”

隨著大模型訓(xùn)練和推理對(duì)算力需求的爆炸式增長(zhǎng),傳統(tǒng)計(jì)算架構(gòu)已難以支撐AI技術(shù)的代際躍遷。

超節(jié)點(diǎn),作為AIDC算力Scale Up的當(dāng)前最優(yōu)解,通過(guò)內(nèi)部高速總線互連,能夠有效支撐并行計(jì)算任務(wù),加速GPU之間的參數(shù)交換和數(shù)據(jù)同步,縮短大模型的訓(xùn)練周期,在性能、成本、組網(wǎng)、運(yùn)維等方面,能為用戶帶來(lái)巨大優(yōu)勢(shì)。

AMD顯然也看到了這個(gè)趨勢(shì)。在Advancing AI大會(huì)上,AMD宣布正式推出Helios AI機(jī)柜基礎(chǔ)設(shè)施,將包括AMD EPYC“Venice” CPU、Instinct MI400系列GPU和Pensando “Vulcano” AI 智能網(wǎng)卡——與ROCm軟件統(tǒng)一整合為一個(gè)完全集成的解決方案。AMD的目標(biāo)非常明確,那就是打造“The World’s Best AI Rack Solution”。

從現(xiàn)場(chǎng)披露的數(shù)據(jù)來(lái)看,Helios AI機(jī)架可容納最多72塊MI400系列GPU,總帶寬260TB/s,HBM4內(nèi)存總?cè)萘?1TB、總帶寬1.4PB/s。整機(jī)性能,Helios AI 機(jī)架可高達(dá) FP8 1.4EFlops ( 140 億億次每秒 ) 、FP4 2.9EFlops ( 290 億億次每秒 ) 。

正如蘇姿豐博士所講的,AMD是唯一具備全面覆蓋數(shù)據(jù)中心、邊緣及終端設(shè)備端到端AI能力的供應(yīng)商,擁有支撐全棧AI所需的硬件矩陣與軟件實(shí)力。在過(guò)去的六年中,AMD EPYC在服務(wù)器CPU市場(chǎng)上實(shí)現(xiàn)了超過(guò)18倍的份額提升,從原來(lái)的2%上升到40%(1Q25);我們完全有理由相信,在更加波瀾壯闊的AI時(shí)代,在“領(lǐng)先技術(shù)+開(kāi)放生態(tài)+全棧方案”的加持下,AMD將會(huì)迎來(lái)新一輪成長(zhǎng)。