隨著大模型技術的飛速發展,多模態智能(即同時理解圖像和文字的AI)也迎來了突破。然而,性能表現優異的視覺-語言模型(Vision-Language Models,VLMs),尤其是推理能力強勁的VLMs,普遍存在參數膨脹的問題,中興通訊受到DeepSeek R1-Zero的啟發,推出了Curr-ReFT (Curriculum Reinforcement Fine-Tuning)訓練范式,為輕量化的VLMs訓練成為推理模型帶來了優秀的訓練思路。

從啟示到創新:Curr-ReFT的誕生

DeepSeek R1-Zero通過“組相對策略優化(Group Relative Policy Optimization, GRPO)”顯著提升了大語言模型在復雜推理任務中的表現,展示了模型基于相對響應自我改進的潛力。中興通訊深度借鑒其理念,結合多模態任務需求,提出了面向小模型后訓練優化的Curr-ReFT范式。

Curr-ReFT訓練范式從復現R1-Zero在多模態數學數據上的訓練起步,發現基礎能力提升有限。為解決這一瓶頸,中興通訊大膽創新,將原本依賴有監督微調的訓練流程,全面轉向以強化學習為核心的方式,實現在計算機視覺(CV)、多模態任務中的全流程重塑,有效突破“Superficial Pattern Matching(表面模式匹配)”問題。

進一步針對輕量VLM在能力提升上遭遇“Brick Wall(瓶頸墻)”的難題,Curr-ReFT引入“課程式強化學習”策略,通過由易到難、循序漸進的三階段任務設計,幫助模型逐步激發推理潛能。同時,結合基于拒絕采樣的高質量微調機制,實現對模型能力的持續優化。

Curr-ReFT訓練范式:重塑輕量化VLM訓練的兩大核心技術

1. 課程強化學習——循序漸進,攻克難題Curr-ReFT借鑒了課堂教學中 “由易到難”的教學理念,將復雜任務拆分為三個階段,逐步提升模型的能力:

·第一階段:二元決策學習,視覺啟蒙模型從最簡單的任務入手,僅需回答“是”或“否”,快速建立基礎的視覺理解和簡單推理能力。例如,AI模型能夠判斷“這是蘋果嗎?”

·第二階段:多項選擇學習,認知躍遷

隨后模型進入選擇題階段,需要從多個選項中挑選正確答案,這一階段既考驗決策能力,也幫助模型學會分辨細節。通過鍛煉觀察力和細節分析,AI模型升級到會分析“水果里哪個最大?“

·第三階段:開放式回答,思維覺醒 最終,模型將面對開放性問題,需要根據圖像和文字信息自由作答。這時,模型的綜合推理能力得到充分鍛煉,最終能描述"這幅畫講的是什么故事"。

這一層層遞進的獎勵機制確保了模型能夠穩步提升,逐步適應越來越復雜的任務,而不會因為過早接觸難題而出現訓練不穩定的情況。

2. 拒絕樣本自我改進——精挑細選,持續自我優化為了在提升復雜推理能力的同時不損失模型的基本語言技能,中興通訊還采用了基于拒絕采樣的自我改進機制。

·首先,我們利用先進的GPT-4-O作為獎勵模型,對模型生成的回答進行全方位評分(包括準確性、邏輯性、格式和流暢度),只有評分超過85分的回答才被挑選出來。

·接著,這些高質量樣本組成一個精編數據集, 這些高分答案成為模型自我學習的參考,通過不斷修正錯誤、優化表現,模型能力持續提升。

這種方法確保模型在不斷進步的同時,始終保持扎實的基礎能力,避免了因過擬合某些簡單任務而影響整體表現。

Curr-ReFT實戰驗證:小模型,大能量

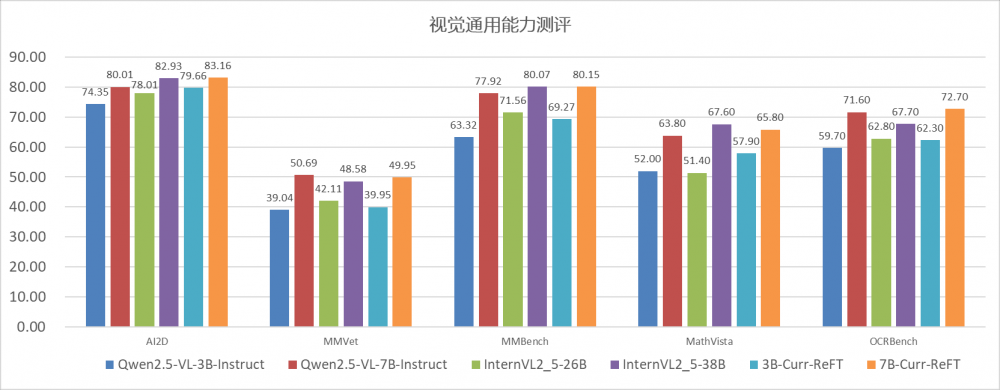

為了全面評估Curr-ReFT后訓練方法的效果,我們選取了Qwen2.5-VL-3B和Qwen2.5-VL-7B兩個基礎模型進行驗證。實驗結果顯示,Curr-ReFT在這兩個模型上的表現均顯著超越了原有基線,甚至在多個公開基準測試中超越了更大規模的26B(InternVL-26B)和32B(Llava-Next-32B)模型。

·推理能力躍升:Curr-ReFT-3B模型在AI2D數學推理測試中準確率達83%,相比原模型的74%提升顯著,甚至超越了多項任務中26B(InternVL-26B)和32B(Llava-Next-32B)的大模型表現。

·泛化能力增強:在Qwen2.5-VL-7B基礎上,Curr-ReFT進一步帶來性能躍遷。視覺檢測準確率從89.8%提升至92.2%,分類任務準確率從71.5%提升至73.1%。在關鍵基準測試中也取得顯著突破(MMVet從29.95%提升至36.78%,MathVista從58.6%提升至92.2%)。

這一系列數據充分證明,Curr-ReFT不僅適配小模型、低算力場景,更具備跨模型、跨任務的通用適應能力。

技術價值全面釋放:小模型,大場景

中興通訊自主研發的Curr-ReFT訓練范式,憑借其核心優勢,為小型視覺語言模型在各類視覺文本任務中提供了堅實保障,具體亮點包括:

·領先技術:中興通訊自主研發的Curr-ReFT訓練范式,使小型VLMs在各類視覺文本任務中展現出卓越的推理和泛化能力。

·高效易用:該技術采用通俗易懂的分階段訓練和拒絕采樣策略,即使在資源有限的環境下,也能實現穩定、快速的模型優化。

·廣泛應用場景:無論是智能終端、邊緣計算平臺還是智算中心,中興通訊的這項創新均能為客戶提供高效、低成本的VLMs解決方案。

攜手創新,智繪未來

中興通訊始終致力于前沿技術的持續探索與突破,將Curr-ReFT這一創新訓練范式深度集成至AIS訓推平臺,不僅大幅簡化了輕量化VLM的訓練流程,更顯著提升了小模型的推理與泛化能力。未來,中興通訊將攜手生態伙伴,共同拓展視覺語言智能的新邊界,賦能千行百業邁向更高效、更普惠的智能新時代。

開源下載鏈接:

代碼:https://github.com/ding523/Curr_REFT

數據:https://huggingface.co/datasets/ZTE-AIM/Curr-ReFT-data

模型權重:https://huggingface.co/ZTE-AIM/3B-Curr-ReFT