C114訊 5月24日消息(張曉寶)5月23日,由CIOE中國光博會與C114通信網聯合舉辦的2024中國高質量發展論壇第四場——“AI時代:數據中心光互聯技術新趨勢”研討會成功舉行,京東光互聯架構師陳琤在會上分享了關于《高性能計算網絡中的光互連》的主題發言。

京東在高性能計算網絡領域起步較早,持續在多個代際的智算拓撲上做了大量的投入,應用場景涉及到了推薦算法、智能客服,AI售賣租賃、數字人直播等等。

智算網絡拓撲一般分為兩類獨立的網絡,其一是接入/存儲網絡,主要實現CPU之間的互聯;其二是計算網絡,主要進行GPU節點數據的并行協同。

整體來看,智算網絡對于光互連的要求主要集中于三方面,即大帶寬、低成本和低延時。

光模塊與大帶寬的關系

數據鏈路帶寬方面,首先要實現的是GPU與GPU之間并行多路的通信,需要注意數據傳輸過程中鏈路帶寬的情況,在計算節點內部互聯中一般可采用C2C Full mesh的方式,連接速率可達數百GB/s。

如要實現不同GPU出口的通信,則要通過PCle與網卡連接,在進行串并轉化后進而通過光模塊、計算網絡實現跨端口連接。因此,當前許多廠家均在提倡光學輸入/輸出(OIO)的形式,以突破高速互聯的瓶頸,這也是當下的一個發展方向。

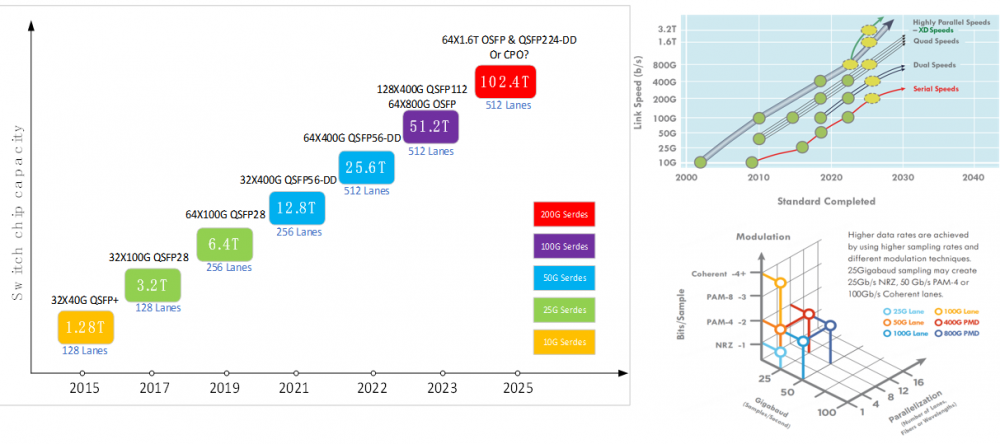

在網絡設備/光模塊帶寬演進方面,當前智算網絡主要部署的是50G Serdes的交換機和光模塊,光模塊類型選擇則以200G/400G等為主。當單節點容量達到51.2T時,根據對網絡可拓展性的要求會去選擇不同的拓撲類型,北美的一些廠家會選擇64x800G OSFP,國內廠家則采用128x400G QSFP 112的封裝,但二者產業鏈是通用的。

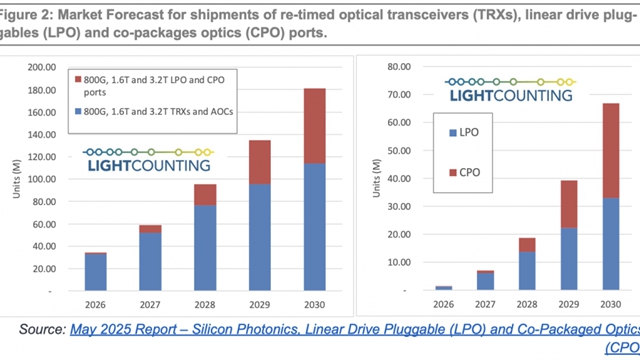

若未來單芯片交換容量達到102.4T,可插拔光模塊依然可以支持高密度大容量的光互連應用,可以選擇64x1.6T OSFP和QSFP224-DD。。CPO也是熱門的解決方案之一,它要繼續解決可靠性的問題,還要解決建設部署中的可維護性問題。

如何降低光互連成本?

在降低光互連低成本問題中,硅基光子技術是潛在的降成本方案之一。硅光并非是全新的技術,但就數據中心應用而言是比較新的產品,當前112G per lane模塊的供應鏈上游集中于少量光器件廠家,因此硅光光模塊可以據此介入,以打破供應緊張問題。

特別硅光模塊是可以覆蓋解決2km以內的所有數據中心應用場景需要的,因此京東也在進行相應的認證等工作,相信不久的將來也能真正的部署到當下網絡中。

線性直驅光模塊LPO/LRO當前也是比較熱門的應用方向,在112G per lane時代,借助于ASIC驅動能力足夠強的特性,可以將光模塊作減法,即去掉DSP或CDR的部分,進而可降低光模塊的復雜程度,以達到降低成本的目的。

但其也面臨了一些挑戰,如兼容性與互聯互通的問題,要考慮ASIC芯片對其的支持情況、不同廠家間互聯情況、新舊模塊互聯互通的情況等等問題。

還有演化可持續性的問題也要考慮進來,如112G已可支持LPO,但如發展至224G等,就要考量LPO是否支持的可行性了。

智算網絡低延時問題

在低延時方面,如要實現整體協同的運算保障,不同的計算節點間的GPU延時問題勢必會大大降低運行效率,那么哪些因素通常會導致延時呢?

首先是基于協議,GPU的網絡最初基于InfiniBand(IB)的協議形式較多,在數據傳輸中可繞過CPU的參與,實現了不同計算節點間GPU緩存之間的數據通信,大大減少了基于協議的通信延時。

基于傳統以太的協議,則要CPU介入到通信整個過程,因此其延時會比較長。

在智算網絡中用到的是一個較為折中的方案,即RDMA方案,可借用以太協議的封裝將RDMA的內核封裝進去,進而實現共用以太網的設施以實現降低延時。

其次則是鏈路延時,因為GPU與GPU之間的通信要經過leaf-spine架構,并要進行光信號轉換,實現數據互聯,其過程中各環節也必然產生各種不同的延時。

如在決策類模型的時延中,可優化項為光模塊中的信號恢復單元導致的延時。而在生成式模型的延時中,主要是數據傳輸時間導致的延時為主,而物理鏈路導致的延時實際占比極小。因此,這時候系統延時會對帶寬利用率更為敏感,要根據模型不同去優化延時的不同方向。

最后陳琤總結到,相較于傳統數通網絡,智算網絡帶寬的增長也會更迅速,低成本互聯有賴于新技術的支撐,如硅光、LPO/LRO等。另外,不同的模型對延時的要求是不一樣的,要優化的方向會有所區別。