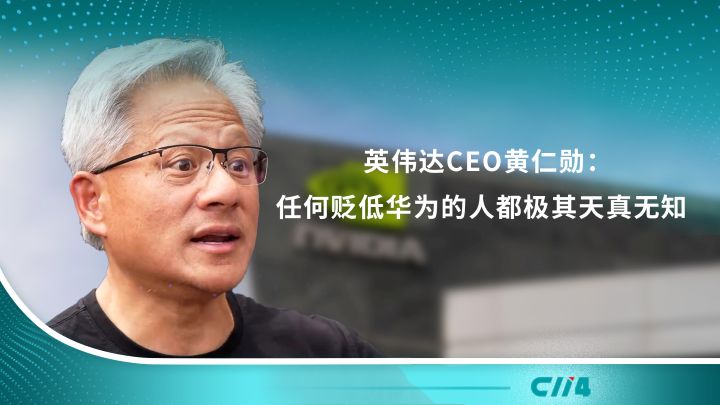

5月21日,在2025騰訊云AI產業應用峰會上,騰訊云副總裁、騰訊云智能負責人、騰訊優圖實驗室負責人吳運聲發表主題演講。吳運聲認為,當前AI應用領域呈現出交互體驗更豐富、模型使用更高效、應用構建更快捷等趨勢。圍繞新的客戶需求,騰訊云在多模態語音交互、模型訓推、智能體開發等層面不斷迭代更新產品能力,幫助用戶把技術創新更快地轉化為實際生產力。

騰訊云副總裁、騰訊云智能負責人、騰訊優圖實驗室負責人 吳運聲

吳運聲提到,為提升用戶與AI應用之間的交互體驗,騰訊云正式發布“騰訊云語音PaaS解決方案”。該方案通過將領先的ASR大模型、TTS大模型與TRTC的實時通信能力深度融合,構建起 “語音輸入→智能處理→自然輸出→實時交互” 的全鏈路閉環,為企業提供低成本、可快速搭建的語音交互解決方案,幫助企業優化用戶交互體驗。

在模型訓推層面,騰訊云TI平臺也實現了全面升級。首先,騰訊云TI平臺升級了精調工具鏈提供蒸餾精調、強化學習等更多訓練方式,并面向自動駕駛領域的廣泛需求推出自駕模型訓練能力。同時,TI平臺在資源調度方面也全面升級,支持訓推一體、潮汐調度。成本是決定大模型是否能落地的關鍵因素之一,TI平臺持續升級內置的Angel加速套件,以業界領先的推理加速能力,幫助企業降本。

從大模型到智能體,AI應用步入“平權時代”。對此吳運聲指出:“智能體的廣泛應用將成為企業創新提效的利器。”為此,騰訊云將大模型知識引擎全面升級為騰訊云智能體開發平臺,通過行業領先的RAG技術、全面的Agent能力、以及實戰打磨出來的匹配用戶需求的功能,幫助用戶在大模型時代快速構建智能體。

他表示,經過多個真實業務場景的打磨,騰訊云智能體開發平臺沉淀出了多項核心能力,不只是“能用”,而是真正能夠貼合企業復雜業務、可落地、可運營,滿足企業的全鏈路需求。例如,QQ瀏覽器基于騰訊云智能體開發平臺,推出了智能體Qbot,通過各種AI助手來幫助用戶執行下載、應用更新等任務。

以下為演講全文:

各位領導、嘉賓、媒體朋友們,

大家上午好!

我是騰訊的吳運聲,很高興在這里跟大家分享騰訊云在大模型工具和智能體開發層面的進展和思考。

前面混元的同事也有提到,今年以來,模型的進展非常快,很多AI原生的應用在涌現。我們看到了幾個明確的趨勢:

首先,大語言模型和多模態模型進一步融合,用戶和AI應用之間的交互,已經從文字進一步演化到語音、視頻等形式。多樣的交互體驗進一步提升了AI應用的滲透率。

其次,訓練和推理的效率持續提升。通過算力管理調度、推理加速優化等手段,算力的利用率不斷提升,模型的使用成本降低,這也進一步推動了模型在更多場景落地。

第三,智能體加速落地。今年以來,智能體這個話題特別熱,智能體能夠實現自主規劃執行路徑、靈活調用工具,極大地降低了企業構建AI應用的門檻。通過智能體開發平臺類的工具,企業可以快速落地智能體。

圍繞著這三個趨勢和客戶需求,我們也在多模態語音交互、模型訓推、智能體開發等層面不斷迭代更新產品能力,幫助用戶把技術創新更快地轉化為實際生產力。

在交互體驗上,我們在語音識別、輸出、實時傳輸等層面不斷優化,力爭為用戶帶來更智能、更擬人的語音交互體驗。

語音識別是語音交互的前置重要模塊,ASR準確率的提升,可以明顯提升全鏈路的智能度。相比較傳統的ASR技術,我們的ASR大模型擁有更強的識別能力,在遠場、噪音等復雜場景下,字錯率明顯下降。同時支持方言識別,還可以動態適應不同口音、不同語速,真正讓AI“聽得懂”。

在輸出層面,我們的TTS大模型在擬人度、韻律自然度上明顯提升,發音接近真人自然對話感。TTS大模型可以快速理解本文內容,用貼合文本情緒的聲音進行演繹,顯著降低了傳統TTS輸出的人機感。

同時,在實時人工智能交互場景中,LLM及時接收和處理用戶的音視頻數據至關重要。TRTC的超低延遲通信確保了全球范圍內音視頻傳輸的端到端延遲低于300ms,同時將對話延遲保持在1000ms以下,近似人類自然對話的響應時間,讓用戶享受到流暢自然的互動。

今天,我們也正式發布“騰訊云語音PaaS解決方案“。

我們將前面提到的 ASR大模型、TTS 大模型與TRTC 的實時通信能力的深度融合,構建起 “語音輸入→智能處理→自然輸出→實時交互” 的全鏈路閉環,為企業提供低成本、可快速搭建的語音交互解決方案,幫助企業優化用戶交互體驗。

在底層,企業也可以靈活接入混元、DeepSeek 等大語言模型服務,實現 AI 與用戶之間的實時互動,打造符合業務場景的 AI 實時對話能力。

面向企業大模型構建的需求,我們的機器學習平臺TI平臺持續升級。

首先是全面升級模型訓練能力。我們及時跟進騰訊混元以及開源社區進展,更新或上架了騰訊混元系列、Deepseek系列,LLama4系列等模型。我們也升級了精調工具鏈,支持更多訓練方式,主要是蒸餾精調和強化學習等。其中,基于DeepSeek R1/V3 蒸餾其他模型,是非常實用的訓練模式,可使用較小模型來提供接近 R1的推理能力,我們提供了詳細的最佳實踐以及配套的數據萃取工具,幫助用戶更高效完成蒸餾。

同時,面向自動駕駛領域的廣泛需求,我們內置了相應的訓練鏡像,可以快速啟動BEVFormer、FastBEV等多個主流自駕模型訓練,降低企業研發啟動成本。

在工具鏈之外,TI 平臺在資源調度方面也全面升級,支持訓推一體、潮汐調度。基于這個能力,TI 平臺能在夜間,將在線推理業務的閑時算力,自動調度給離線訓練任務和離線數據處理任務,從而大幅提升資源利用率。與此同時,我們也提供了靈活可配置的排隊策略,滿足不同場景下的排隊、調度需求。

某頭部消費電子企業,基于 TI 平臺統一管理集團算力,支撐了大模型和傳統CV小模型的研發,應用在電視產品文案生成、視頻分析等場景。基于 TI平臺提供的精調工具鏈和資源管理能力,AI研發整體提效50%以上,GPU資源利用率也提升了80%以上。

成本是決定大模型是否能落地的關鍵因素之一,TI平臺持續升級內置的Angel加速套件,以業界領先的推理加速能力,幫助企業降本。

在技術升級方面,我們通過深挖內核和架構延展,在精度幾乎無損的前提下,實現服務時延的大幅降低,以及吞吐能力的大幅提升。相關加速能力支持社區主流的SGLang和VLLM兩個引擎。

近期,我們對SGLang推理框架的優化也獲得了SGLang核心作者的認可,感謝我們對FlashMLA后端進行了深度優化,相關技術方案已經貢獻至開源社區。當然,我們面向商業化客戶會提供經過更加嚴謹測試的、性能更優異的版本。

基于以上技術優化,我們實現了行業領先的加速性能。我們在控制首token延時、并保障吐字速率的同時,大幅提升了QPM。比如在3.5K輸入、1K輸出的典型場景下, 保障首Token延時不高于2秒,吐字速率不低于每秒20 Tokens的同時,2機16卡的QPM可以超過100。當前這些性能都是行業領先的。

上述加速能力,我們也已經在行業內進行交付和應用。某頭部新能源汽車制造商基于TI平臺統一納管算力部署DeepSeek專屬模型,支撐知識問答、營銷、座艙語音助手等多個業務場景。在使用TI平臺提供的Angel加速能力后,DeepSeek的模型綜合性能顯著提升,資源成本顯著降低。

從模型到智能體,AI應用落地的門檻正在逐步降低。智能體的廣泛應用或將成為企業創新提效的利器。知識庫、插件工具、Multi-Agent框架等正在驅動著智能體不斷升級,成為懂企業知識、能調用工具、自主執行復雜任務的得力助手。

今天,我們將大模型知識引擎全面升級為騰訊云智能體開發平臺,通過行業領先的RAG技術、全面的Agent能力、以及實戰打磨出來的匹配用戶需求的功能,幫助用戶在大模型時代快速構建智能體。

我們始終相信,企業的智能化能力,必須建立在對企業私域知識的深度激活和挖掘之上。只有懂企業知識,智能體才能發揮最大價值。

我們的RAG能力行業領先,能夠實現:

從復雜 Excel 表中精準提取答案,支持對接數據庫,通過Text2SQL,用戶用自然語言即可精準查詢、秒級返回。

支持從文檔自動生成問答對,并對完整的問答進行校對和管理,全流程可控,顯著降低運營人力投入的時間成本。

同時,支持文檔間比對,輔助高效決策,支持版本對照,高亮增刪改的內容,配套 “保留兩者 / 刪除舊版 / 合并更新” 等處理方案一鍵執行,支持僅對變更片段生成問答對,顯著降低token消耗。

借助這三項能力,企業可以用最小的投入快速完成知識更新與決策閉環,為智能體持續進化奠定堅實基礎。

在RAG基礎上,我們提供了全面的 Agent 能力支持。這些能力源自大量企業場景的實戰打磨,既保障了落地所需的穩定性和確定性,又保留了對話智能的靈活性,真正實現了易用上手與復雜場景適配的雙重兼顧。

比如,我們在工作流中首創具備全局視野的Agent,支持參數回退和全局意圖洞察,對話表現靈活自然;

同時,我們首創零代碼配置多Agent協同轉交,簡單易上手的轉交關系配置,讓用戶能輕松實現模型驅動的自動協作,構建“多專家”體系,有效分擔單體 Agent 的任務壓力;

在插件生態上,我們全面支持MCP協議,平臺預置了豐富的騰訊內、外部插件,開箱即用;同時支持自定義插件快速接入,極大提升系統擴展性與可組合性;

依托穩定的工作流編排、多智能體協同機制和完善的 MCP 插件生態,企業可以快速搭建高可用、可演進的專屬智能體系統。

經過多個真實業務場景的打磨,我們的智能體平臺沉淀出了多項核心能力,不只是“能用”,而是真正能夠貼合企業復雜業務、可落地、可運營,滿足企業的全鏈路需求。

首先,我們提供完善的權限體系配置體系。

支持平臺級、應用級、知識庫級的多層權限體系配置,不管是按組織架構、崗位角色,還是黑白名單控制,都可以靈活支持。比如,騰訊學堂是服務于騰訊內部的培訓平臺,知識規模龐大,權限體系復雜。基于我們的平臺,結合外部權限控制的方式,騰訊學堂可以靈活配置權限,快速落地問答助手。

其次,我們支持意圖達成方式的配置。

在實際業務中,不同場景對意圖響應的優先級存在差異。在我們的平臺上,用戶可以按業務需求靈活設定響應路徑,確保優先走最合適的方式。如果存在多個易混淆意圖,模型同時給出多個意圖候選,引導用戶選擇。

第三,我們的平臺提供真正面向上線運營的全鏈路支持。

從智能體發布上線,到后續的運營監控、配置管理,我們都有完善的 OP 系統支持。無論是企業級 TPM/QPM 配置,還是體驗應用的配置管理,都能實現精細化運維,并支持私有化部署,真正讓企業用得放心、運維省心。

依托這些在實戰中打磨出的能力,我們的平臺已經服務了內、外部的眾多客戶,在很多場景中成功落地,真正解決了企業在智能化應用中遇到的核心問題,把AI變成生產力。

比如,QQ瀏覽器基于騰訊云智能體開發平臺,推出了智能體Qbot,通過各種AI助手來幫助用戶執行下載、應用更新等任務。接下來,我們來通過一個視頻看下如何通過智能體開發平臺搭建一個下載助手Agent。

在實際的使用場景中,我們通常需要多個agent協同去完成復雜任務。現在借助我們的語音交互能力,我們可以直接口頭指揮agent去完成任務,接下來我們也可以來看下多個agent是怎么協同完成寄快速任務的。

可以看到,通過多Agent的協作,智能體已經能夠非常靈活地處理用戶的各項需求。剛剛這個演示中涉及的產品能力,我們也正在持續打磨中。在內部環境驗證中,部分環節處理的時間會稍微長一點。所以在這個視頻里面,我們做了一些加速處理。

我們相信,隨著大模型的持續進化和各項工具、框架的升級,產品的體驗會進一步得到優化,智能體一定能夠成為企業和用戶的得力助手。也歡迎大家掃碼試用我們的騰訊云智能體開發平臺。

未來,騰訊也將圍繞客戶需求,持續打磨產品,為各行各業用好大模型、用好智能體提供助力!