科技媒體 marktechpost 昨日(5 月 14 日)發布博文,報道稱 Meta AI 旗下 FAIR 團隊攜手佐治亞理工學院,合作開發 CATransformers 框架,將碳排放作為核心設計考量,通過聯合優化模型架構與硬件性能,顯著降低總碳足跡,為可持續 AI 發展邁出重要一步。

機器學習技術的普及推動了從推薦系統到自動駕駛的革新,但其環境代價不容小覷。這些系統需要強大計算資源,常依賴定制硬件加速器運行,訓練和推理階段的高能耗直接導致運營碳排放攀升。

此外,硬件從制造到報廢的全生命周期也產生“隱含碳”,加劇生態負擔。隨著全球各行業加速采用 AI 技術,解決運營與隱含碳的雙重來源成為迫切需求。

當前減排方法主要集中于提升運營效率,例如優化訓練和推理的能耗,或提高硬件利用率。但這些方法往往忽略硬件設計和制造階段的碳排放,未能整合模型設計與硬件效率的相互影響。

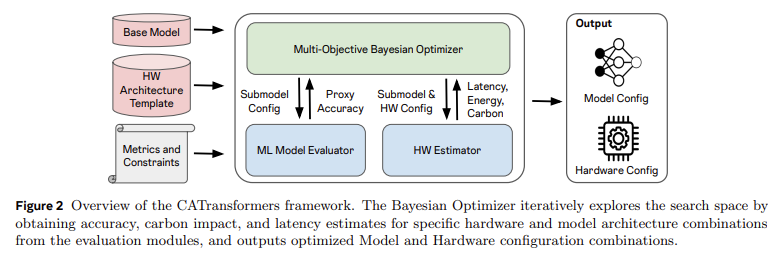

Meta 的 FAIR 團隊與佐治亞理工學院聯合推出的 CATransformers 框架,將碳排放納入核心設計考量。該框架通過多目標貝葉斯優化引擎,聯合評估模型架構與硬件加速器的性能,平衡延遲、能耗、精度和總碳足跡。

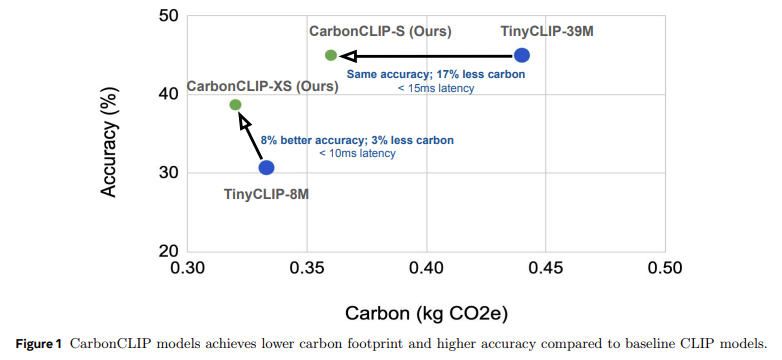

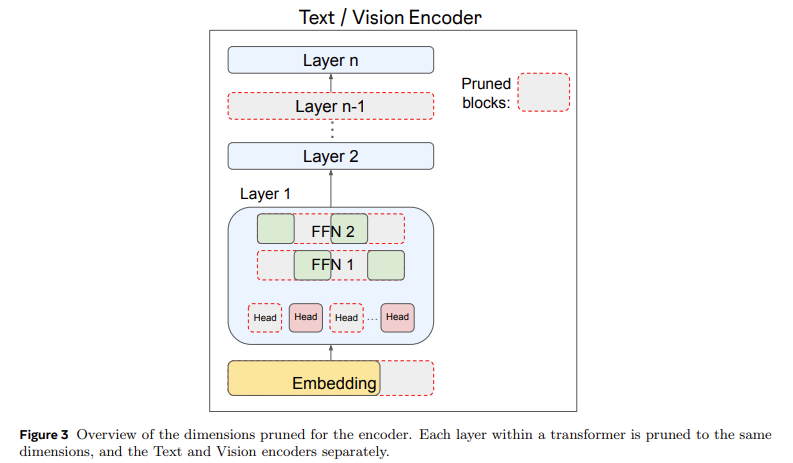

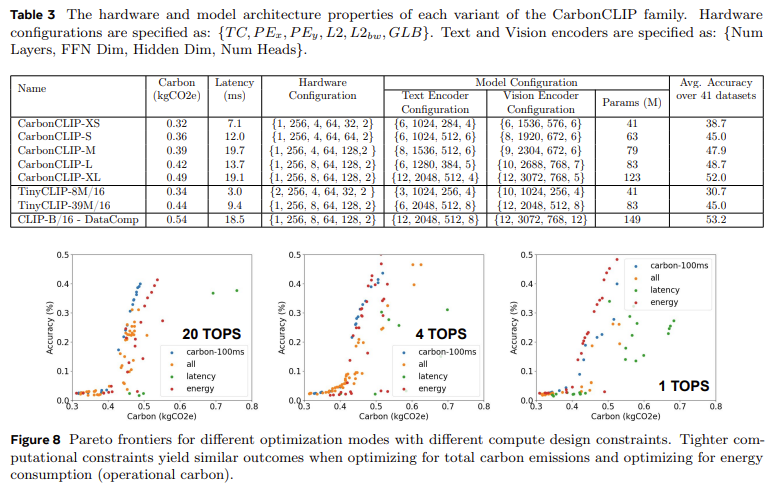

特別針對邊緣推理設備,CATransformers 通過剪枝大型 CLIP 模型生成變體,并結合硬件估算工具分析碳排放與性能。其成果 CarbonCLIP-S 與 TinyCLIP-39M 精度相當,但碳排放降低 17%,延遲控制在 15 毫秒內;CarbonCLIP-XS 則比 TinyCLIP-8M 精度提升 8%,碳排放減少 3%,延遲低于 10 毫秒。

研究顯示,單純優化延遲的設計可能導致隱含碳增加高達 2.4 倍,而綜合優化碳排放與延遲的策略可實現 19-20% 的總排放削減,且延遲損失極小。

CATransformers 通過嵌入環境指標,為可持續機器學習系統設計奠定基礎。這表明,AI 開發若從一開始就結合硬件能力與碳影響考量,可實現性能與可持續性的雙贏。隨著 AI 規模持續擴大,該框架為行業提供了切實可行的減排路徑。