近日,江蘇移動、移動研究院,聯合華為在無錫完成面向車路云一體化的核心網多源融合感知技術試點,是該技術在全國首次實現與車聯網的結合應用,突破傳統感知與5G-A通感邊界,為車路云業務提供可靠、靈活、低時延、高精度的融合感知解決方案,標志著中國移動在5G-A通感能力賦能場景創新上又邁出重要一步。

為貫徹落實《新能源汽車產業發展規劃(2021-2035年)》(國辦發〔2020〕39號),推動網聯云控基礎設施建設,加快智能網聯汽車技術突破和產業化發展,工信部等五部委發布《開展智能網聯汽車“車路云一體化”應用試點工作》的通知并推動相關項目,標志著車路云產業將由過去示范區形式的小規模方案驗證,邁向城市級的規模化、標準化、商業化的落地實踐,過程中面臨諸多挑戰:

將過去“盆景”式的建設方案復制到整個城市,建設成本過高。

計算設備部署在室外,可靠性下降且不利于集中運維。

各類感知源數據質量參差不齊,跨模態差異大,復雜環境下感知能力降低,且當前遮擋和多目標環境存在感知盲區,無法進行軌跡穩定跟蹤。

受業務場景需求和算力資源影響,在低空、車路和海域等場景大多采用定制化方案,計算成本高。

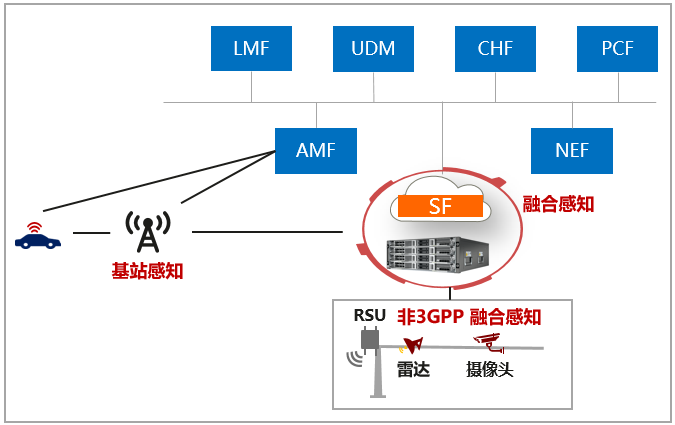

針對車路云一體化方案在落地實踐中的挑戰,江蘇移動與移動研究院聯合華為,提出了基于核心網的由單源基站雷達感知向多源融合感知演進的架構和路線,為車路云一體化提供低成本、易運維、高性能的感知方案:

統一通感網元:創新提出編排調度框架和多源分級融合感知模型,兼顧感知精度和AI算力性能需求,實現一套通感網元同時應用于低空、海域、車路等多個場景,解決感知任務、AI模型和算力間高效協同調度問題。

雷視多模融合:同時支持3GPP感知源(基站感知)與非3GPP感知源(攝像機、激光雷達等) ,基于路側鳥瞰視圖的特征級融合方案,解決遠處小目標識別難、復雜場景虛警高等技術難題。

時空關聯預測跟蹤:提出多目標數據匹配、斷點遮蔽接續以及跨鏡頭關聯等時空預測跟蹤算法,解決在遮擋/電磁下場景下,目標識別定位精差、軌跡接續難的技術挑戰。

集中邊緣部署:提供超高可靠性、極簡運維和彈性伸縮能力,實現路口運維向中心統一運維演進、算力按需靈活部署。

圖1:面向車路云一體化的核心網多源融合感知架構

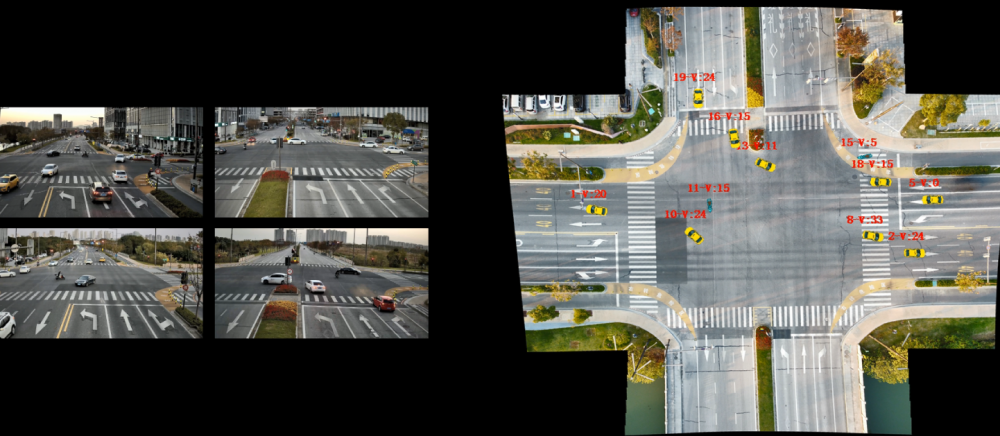

基于上述創新方案,江蘇移動在無錫和風路-立德道完成試點驗證,首次實現視頻、毫米波雷達和激光雷達等多源感知數據的融合與計算,對交通參與者(車輛/騎行者/行人/障礙物)與交通事件(包括超速/低速/鬼探頭/逆行/異常停車)等業務場景能夠進行高精判別,試驗結果達成SL2(感知等級)水平,滿足車路云一體化輔助駕駛的需求。后續會在此基礎上進一步驗證基站感知與多模一體化協同、環境感知等技術的融合及應用,目標達成SL3水平,滿足車路云一體化自動駕駛需求。

圖2:無錫試點感知效果演示

未來,隨著5G-A通感技術的進一步成熟,移動通信網絡將突破傳統連接邊界,逐步演進為集通信、感知、計算、智能于一體的核心中樞,催生“網絡即傳感器”的新型基礎設施范式,在能力上突破感知服務從單一功能向多維協同的跨越,在應用場景上實現從車路云向低空、智能制造等全域的演進,為我國數字經濟高質量發展注入新動能。