阿里通義千問 Qwen 團隊昨日(5 月 26 日)發(fā)布 QwenLong-L1-32B 模型,是其首個通過強化學(xué)習(xí)訓(xùn)練的長文本情境推理模型(LRM)。

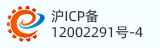

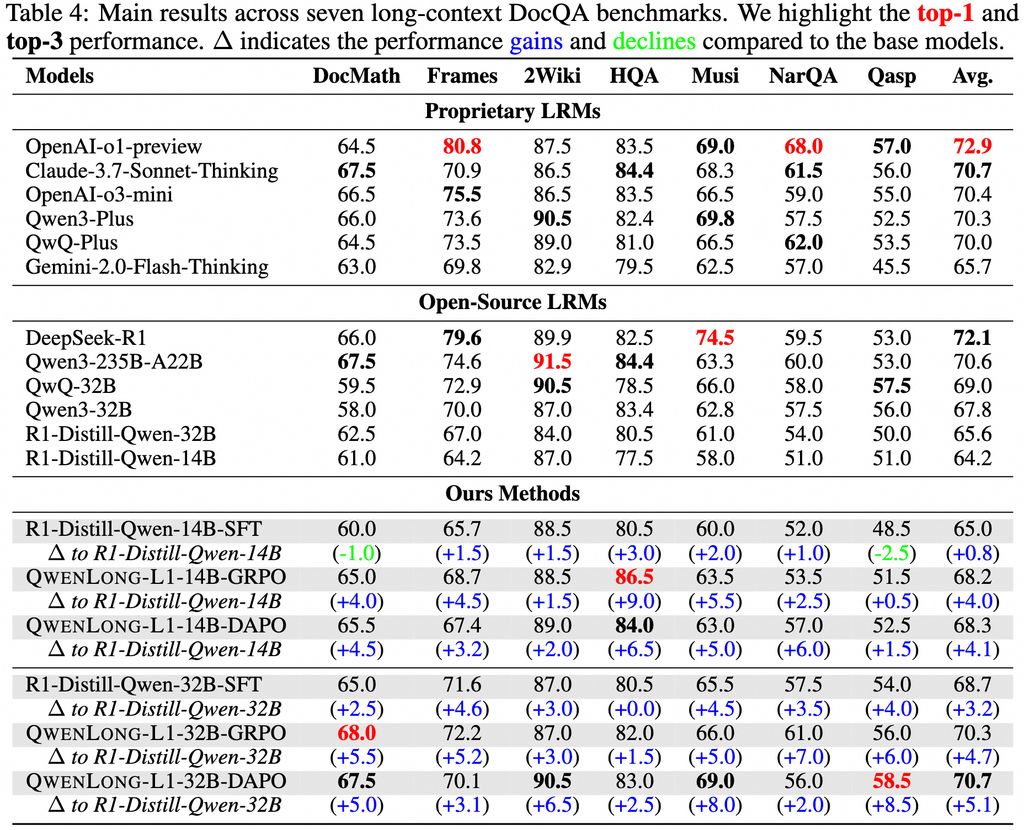

在七個長文本 DocQA 基準(zhǔn)測試中,表現(xiàn)超越 o3-mini 和 Qwen3-235B-A22B 等旗艦?zāi)P停c Claude-3.7-Sonnet-Thinking 相當(dāng)。

QwenLong-L1-32B 模型最大的亮點,在于上下文窗口最高支持 131072 個 tokens。該模型基于 QwenLong-L1 框架開發(fā),采用了先進的 GRPO(Group Relative Policy Optimization)和 DAPO(Direct Alignment Policy Optimizatio)算法,結(jié)合基于規(guī)則和基于模型的混合獎勵函數(shù),顯著提升了模型在長上下文推理中的準(zhǔn)確性和效率。

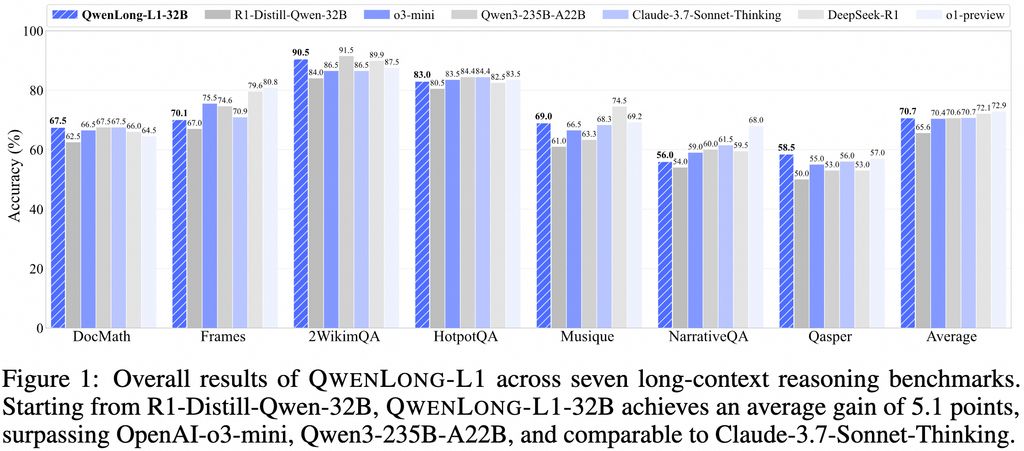

具體而言,團隊在監(jiān)督微調(diào)(SFT)階段建立一個穩(wěn)健的初始策略,隨后采用課程引導(dǎo)的分階段強化學(xué)習(xí)技術(shù)來穩(wěn)定策略演變,并結(jié)合難度感知的回顧采樣策略來激勵策略探索。

除了模型本身,阿里還發(fā)布了一套針對長文本推理問題的完整解決方案。該方案包含四個核心組件: 高性能的 QwenLong-L1-32B 模型、專門優(yōu)化的訓(xùn)練數(shù)據(jù)集、創(chuàng)新的強化學(xué)習(xí)訓(xùn)練方法,以及全面的性能評估體系。